Em 1965, cofundador da Intel Gordon Moore publicou um papel notavelmente presciente que previu que o poder de computação dobraria a cada dois anos. Por meio século, este processo de duplicação provou ser tão consistente que hoje é comumente conhecido como lei de Moore e impulsionou a revolução digital.

Na verdade, ficamos tão acostumados com a ideia de que nossa tecnologia fica mais poderosa e mais barata que mal paramos para pensar em como ela é sem precedentes. Certamente, não esperávamos que cavalos ou arados - ou mesmo motores a vapor, automóveis ou aviões - dobrassem sua eficiência em um ritmo contínuo.

No entanto, as organizações modernas passaram a contar com a melhoria contínua a tal ponto que as pessoas raramente pensam sobre o que isso significa e, com Lei de Moore prestes a acabar , isso vai ser um problema. Nas próximas décadas, teremos que aprender a viver sem a certeza da lei de Moore e operar em um nova era de inovação isso será profundamente diferente.

O gargalo de Von Neumann

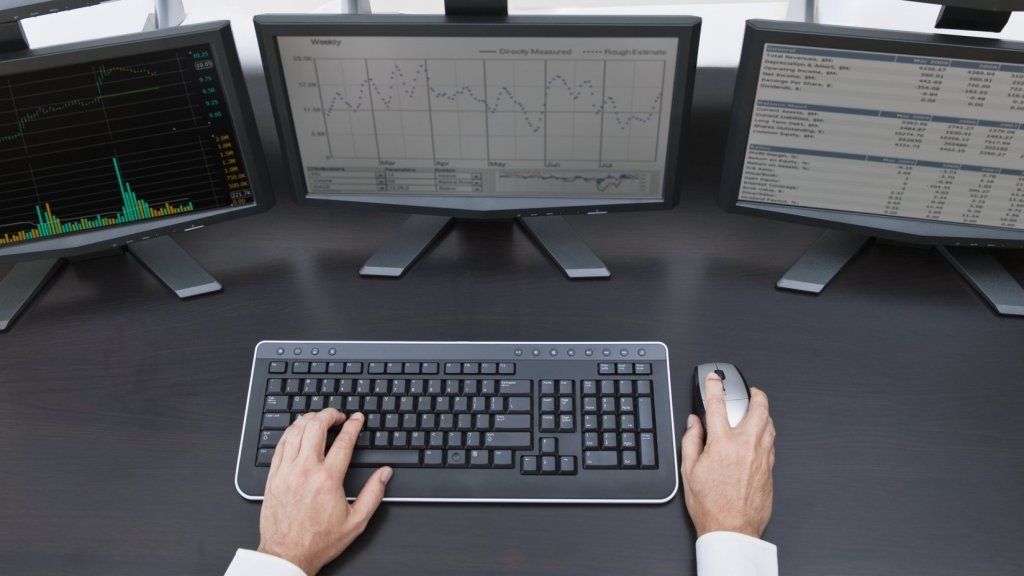

Devido ao poder e à consistência da Lei de Moore, passamos a associar o avanço tecnológico às velocidades do processador. No entanto, essa é apenas uma dimensão do desempenho e há muitas coisas que podemos fazer para que nossas máquinas façam mais a um custo menor do que apenas acelerá-las.

Um exemplo principal disso é chamado de do gargalo de Neumann , que recebeu o nome do gênio matemático responsável pela maneira como nossos computadores armazenam programas e dados em um lugar e fazem cálculos em outro. Nos anos 1940, quando essa ideia surgiu, foi um grande avanço, mas hoje está se tornando um problema.

O problema é que, por causa da Lei de Moore, nossos chips funcionam tão rápido que, no tempo que as informações levam para viajar entre os chips - não menos na velocidade da luz - perdemos muito tempo valioso de computação. Ironicamente, à medida que a velocidade do chip continua a melhorar, o problema só vai piorar.

A solução é simples no conceito, mas elusiva na prática. Assim como integramos transistores em um único wafer de silício para criar chips modernos, podemos integrar diferentes chips com um método chamado Empilhamento 3D . Se pudermos fazer isso funcionar, podemos aumentar o desempenho por mais algumas gerações.

Computação Otimizada

Hoje usamos nossos computadores para uma variedade de tarefas. Escrevemos documentos, assistimos a vídeos, preparamos análises, jogamos games e fazemos muitas outras coisas no mesmo dispositivo usando a mesma arquitetura de chip. Podemos fazer isso porque os chips usados por nossos computadores são projetados como uma tecnologia de uso geral.

Isso torna os computadores convenientes e úteis, mas é terrivelmente ineficiente para tarefas de computação intensiva. Há muito tempo existem tecnologias, como ASIC e FPGA, que são projetados para tarefas mais específicas e, mais recentemente, GPU's tornaram-se populares para funções gráficas e de inteligência artificial.

À medida que a inteligência artificial ganhou destaque, algumas empresas, como Google e Microsoft começaram a projetar chips especificamente projetados para executar suas próprias ferramentas de aprendizado profundo. Isso melhora muito o desempenho, mas você precisa fazer muitos chips para fazer a economia funcionar, portanto, isso está fora do alcance da maioria das empresas.

A verdade é que todas essas estratégias são apenas paliativos. Eles nos ajudarão a continuar avançando na próxima década ou mais, mas com o fim da Lei de Moore, o verdadeiro desafio é apresentar algumas ideias fundamentalmente novas para a computação.

Arquiteturas profundamente novas

Ao longo do último meio século, a Lei de Moore se tornou sinônimo de computação, mas fizemos máquinas de calcular muito antes do primeiro microchip ser inventado. No início do século 20, a IBM foi pioneira em tabuladores eletromecânicos, depois vieram os tubos de vácuo e os transistores antes dos circuitos integrados serem inventados no final dos anos 1950.

Hoje, existem duas novas arquiteturas emergentes que serão comercializadas nos próximos cinco anos. O primeiro é computadores quânticos , que têm o potencial de ser milhares, senão milhões, de vezes mais poderosos do que a tecnologia atual. Tanto a IBM quanto o Google construíram protótipos funcionais e Intel, Microsoft e outros têm programas de desenvolvimento ativos.

A segunda abordagem principal é computação neuromórfica , ou chips baseados no design do cérebro humano. Eles se destacam em tarefas de reconhecimento de padrões com as quais os chips convencionais têm problemas. Eles também são milhares de vezes mais eficientes do que a tecnologia atual e podem ser reduzidos a um único núcleo minúsculo com apenas algumas centenas de 'neurônios' e até matrizes enormes com milhões.

No entanto, essas duas arquiteturas têm suas desvantagens. Os computadores quânticos precisam ser resfriados até quase zero absoluto, o que limita seu uso. Ambos exigem uma lógica profundamente diferente dos computadores convencionais e precisam de novas linguagens de programação. A transição não será perfeita.

Uma nova era de inovação

Nos últimos 20 ou 30 anos, a inovação, especialmente no espaço digital, tem sido bastante simples. Pudemos contar com a tecnologia para melhorar em um ritmo previsível e isso nos permitiu prever, com alto grau de certeza, o que seria possível nos próximos anos.

Isso levou a maioria dos esforços de inovação a se concentrar em aplicativos, com grande ênfase no usuário final. As startups que foram capazes de projetar uma experiência, testá-la, adaptar-se e iterar rapidamente poderiam superar as grandes empresas que tinham muito mais recursos e sofisticação tecnológica. Isso fez da agilidade um atributo competitivo definidor.

Nos próximos anos, o pêndulo provavelmente oscilará das aplicações de volta às tecnologias fundamentais que as tornam possíveis. Em vez de confiar em velhos paradigmas confiáveis, estaremos em grande parte operando no reino do desconhecido. De muitas maneiras, começaremos de novo e a inovação será mais parecida com a das décadas de 1950 e 1960

A computação é apenas uma área atingindo seus limites teóricos. Nos também precisamos baterias de última geração para alimentar nossos dispositivos, carros elétricos e a rede. Ao mesmo tempo, novas tecnologias, como genômica, nanotecnologia e robótica estão se tornando ascendentes e até mesmo o método científico está sendo questionado .

Portanto, agora estamos entrando em uma nova era de inovação e as organizações que irão competir de forma mais eficaz não serão aquelas com capacidade de romper, mas aquelas que estão dispostas a enfrentar grandes desafios e explorar novos horizontes.